L’erreur la plus coûteuse dans un produit numérique n’est pas une mauvaise couleur de bouton. C’est de découvrir trop tard que l’idée était mal comprise, que la promesse n’inspire pas confiance, ou que le parcours ne tient pas sans assistance.

À ce moment-là, l’équipe est déjà engagée : design avancé, développements démarrés, arbitrages politiques, dépendances techniques. Chaque correction devient une négociation et un coût.

Tester tôt, ce n’est pas “faire de l’UX pour l’UX”, c’est réduire mécaniquement les reworks. Parce qu’un test précoce déplace les erreurs au moment où elles sont les moins chères : quand une phrase se réécrit, quand un écran se redessine en une heure, quand une hypothèse s’abandonne sans impacter le planning.

Les décideurs y gagnent en maîtrise : moins d’allers-retours, moins de dette, plus de certitude dans les choix. Et surtout, un signal fiable sur ce qui fonctionne avant d’investir.

Dans un contexte où les roadmaps sont saturées et les équipes sous tension, la meilleure optimisation n’est pas de “faire plus vite”, mais de “faire moins à refaire”.

Tester tôt pour réduire les reworks : un plan UX en 10 jours, preuves à l’appui

Concrètement, tester tôt ne veut pas dire attendre un prototype haute fidélité et un panel de 30 personnes.

Quatre formats simples suffisent à éliminer une grande partie des risques, souvent en une semaine : le test de concept, le tri de cartes, le prototype papier et le test de copy.

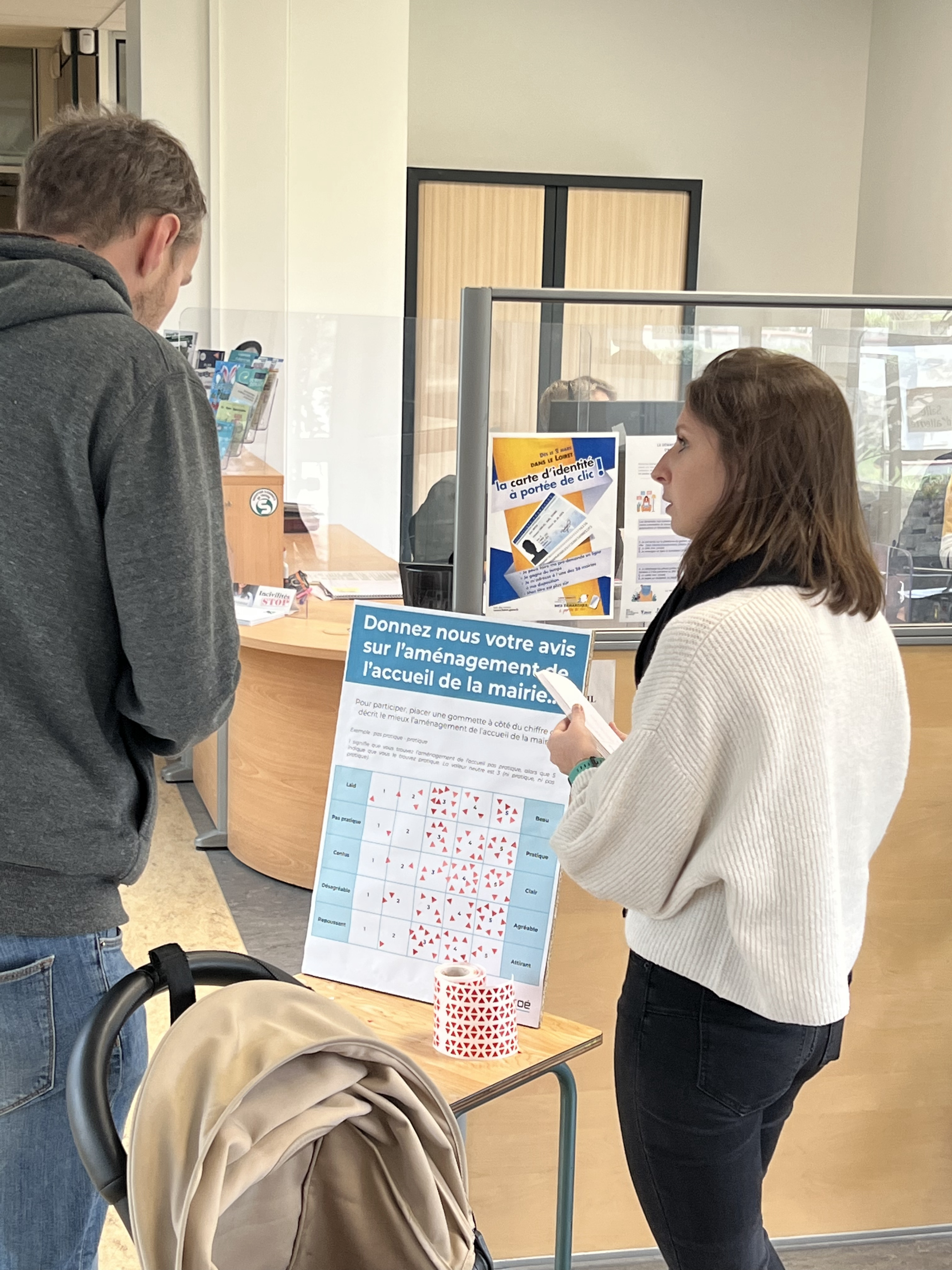

Le test de concept sert à valider la proposition de valeur avant de parler d’interface.

On présente une version courte et claire : pour qui, quel problème, quel bénéfice, en quoi c’est différent. On observe si la personne reformule correctement, si elle voit un intérêt réel et si elle exprime une intention crédible (pas un “oui c’est bien” poli).Le tri de cartes, lui, permet de vérifier la logique de structuration : comment les utilisateurs regroupent-ils les contenus ou fonctionnalités, quels mots utilisent-ils, quelles catégories créent-ils spontanément.

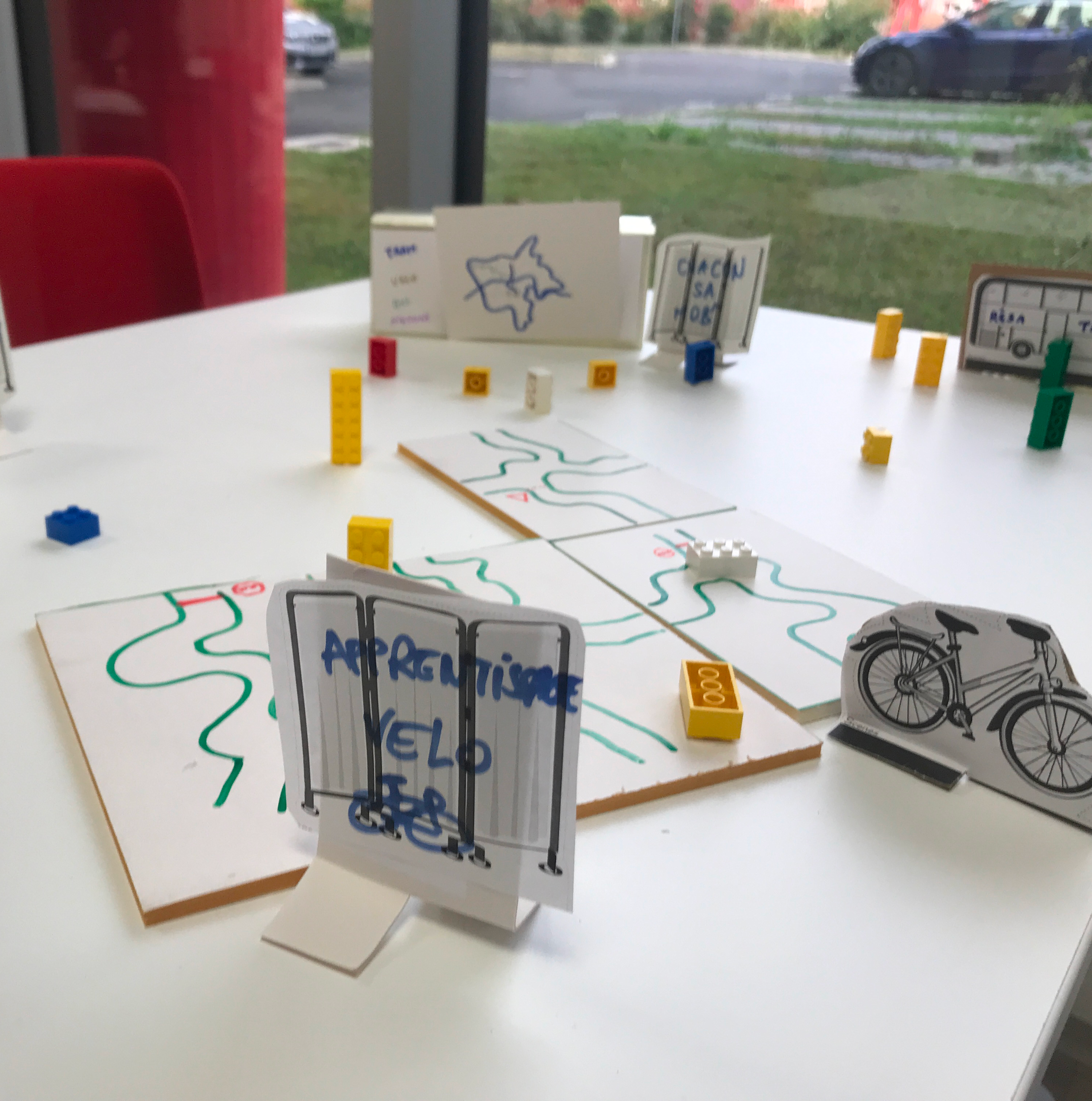

C’est une manière rapide d’éviter une arborescence “interne” qui reflète l’organisation de l’entreprise plutôt que la réalité des usages.Le prototype papier, souvent sous-estimé, permet d’exposer un flux, une navigation et des décisions clés sans dépendre d’outils ni de pixel-perfect.

On simule le parcours, on observe les hésitations, les retours en arrière, les moments où la personne demande “je clique où ?”.Enfin, le test de copy est un levier direct sur la compréhension et la confiance. En testant des titres, CTA, messages d’erreur ou microcopy de formulaires, on réduit des frictions qui génèrent abandon et support.

Ces tests sont légers, mais pas “approximatifs” : ils donnent des preuves qualitatives solides, et souvent des métriques simples, utiles à la décision.

Voici un planning type sur 10 jours, réaliste pour une équipe produit, avec 5 sessions courtes.

L’objectif est d’apprendre vite, sans transformer l’agenda en usine à tests.

Jour 1 : cadrage. Clarifiez l’hypothèse principale (ex. “les responsables RH comprennent et adoptent notre offre self-service”), la décision attendue à J10 (go/no-go, pivot, priorités), et le recrutement (5 personnes correspondant à la cible, pas des collègues).

Préparez un script et un kit de test : concept en une page, liste de cartes pour le tri, écrans papier ou wireframes, variantes de copy.Jour 2 : test de concept (session 1, 30 minutes). Présentez la promesse sans raconter l’histoire du produit. Demandez une reformulation, puis explorez objections et attentes.

Jour 3 : tri de cartes (session 2, 30 à 40 minutes). Faites classer 20 à 30 items maximum, puis demandez de nommer les catégories. Vous cherchez les regroupements naturels et les mots qui “font sens” pour la cible.

Jour 4 : synthèse intermédiaire (1 à 2 heures). Ajustez l’arborescence, identifiez les incompréhensions récurrentes, préparez le prototype papier.

Jour 5 : prototype papier (session 3, 30 à 45 minutes). Faites réaliser un parcours clé de bout en bout : découverte, compréhension, action principale, confirmation. Notez les points où la personne hésite, revient en arrière, ou attend une aide.

Jour 6 : itération rapide (2 à 4 heures). Corrigez l’ordre des étapes, simplifiez les choix, supprimez ce qui crée de la confusion.

Jour 7 : test de copy (session 4, 20 à 30 minutes). Testez 2 à 3 variantes pour les zones sensibles : proposition de valeur, CTA principal, messages d’erreur, explications de champ. Le but n’est pas d’élire la plus “jolie”, mais celle qui est comprise et inspire confiance.

Jour 8 : consolidation (1 à 2 heures). Figez une version “testable” du flux et de la copy.

Jour 9 : test de validation du parcours (session 5, 30 à 45 minutes). Rejouez le même scénario sur la version ajustée, idéalement avec un profil similaire mais nouveau participant si possible.

Jour 10 : synthèse décisionnelle (2 heures). Transformez les apprentissages en décisions : ce qu’on garde, ce qu’on change, ce qu’on abandonne, et ce qu’on teste plus tard.

Livrable attendu : une page de recommandations priorisées, avec preuves (verbatims, erreurs observées, taux de réussite), et impact sur la roadmap.

Ce planning marche parce qu’il alterne test et itération, et parce qu’il limite le nombre de sessions tout en maximisant la diversité des signaux (concept, structure, flux, mots).

Pour que ces tests soient réellement utiles aux décideurs, il faut mesurer 3 choses, simplement et systématiquement : compréhension, confiance, capacité à terminer sans aide.

La compréhension se mesure par la reformulation : “Expliquez-moi avec vos mots ce que fait ce produit” ou “À quoi sert cette étape ?”.

On note si la réponse est correcte, partielle ou à côté. On peut aussi mesurer le temps jusqu’à la première compréhension stable (quand la personne n’hésite plus sur ce que c’est).

La confiance se repère dans les signaux d’acceptation ou de doute : “J’ai peur de…”, “Je ne suis pas sûr que…”, “Je peux annuler ?”, “C’est sécurisé ?”.

Pour la rendre mesurable, demandez une note simple (0 à 10) : “À quel point vous seriez à l’aise pour faire cette action avec vos données / votre budget ?” puis demandez pourquoi.

Enfin, la capacité à terminer sans aide est l’indicateur le plus proche de la réalité opérationnelle : l’utilisateur réussit-il le parcours sans que vous le guidiez ? Mesurez un taux de réussite (réussi/échoué), le nombre d’indices donnés, le nombre d’erreurs, et les points de blocage.

Une règle pratique : si vous devez intervenir plus d’une fois pour débloquer, le parcours n’est pas autonome.

Ces mesures, même sur 5 personnes, suffisent à prioriser. Vous ne cherchez pas une statistique, vous cherchez des problèmes récurrents et coûteux.

Si 3 personnes sur 5 ne comprennent pas la promesse, ce n’est pas “à peaufiner plus tard”, c’est un risque de go-to-market.

Si 4 sur 5 doutent au moment de payer ou de soumettre des informations, ce n’est pas un détail, c’est un futur goulet de conversion et une source de tickets support.

Et si personne ne termine sans aide, vous n’avez pas un problème d’interface : vous avez un problème de conception du parcours.

Pour conclure, tester tôt est une décision de gestion des risques, pas une option “design”. En 10 jours et 5 sessions courtes, vous pouvez valider une proposition de valeur, sécuriser une structure, rendre un parcours autonome et clarifier les mots qui déclenchent la confiance.

Action immédiate : choisissez un parcours critique, formulez une hypothèse unique, recrutez 5 profils cibles, puis exécutez le planning ci-dessus en mesurant compréhension, confiance et capacité à terminer sans aide.

À J10, vous aurez des preuves pour trancher, et surtout, vous aurez évité des semaines de reworks invisibles qui finissent toujours par coûter plus cher que le test lui-même.

Et si on échangeait ?

Cela fait sens pour vous et

vous souhaitez comprendre comment on peut

l’appliquer dans votre contexte ?